Punture di spillo. Se l’IA impara a ragionare... tutto si complica

- a cura di Pietro Terna

- 18 set 2024

- Tempo di lettura: 4 min

a cura di Pietro Terna

L’intelligenza artificiale impara a ragionare e tutto si complica: esploriamo le innovazioni che stanno arrivando e consideriamo il complesso rapporto che si crea nel dialogo tra una persona e una macchina. È importante tenersi al corrente su entrambi gli aspetti, divulgarli e discuterne, molto più che scrivere regolamenti e divieti.

Per un flash su “a che punto siamo” concentriamo l’attenzione ancora una volta sul novembre 2022, quando fu annunciata la novità di ChatGPT, un chiacchierone sapiente capace di interagire in molte lingue su qualsiasi argomento. Sbaglia, certo, ma la novità è tanto sorprendente che Geoffrey Hinton – studioso straordinariamente importante, autore con David Rumelhart and Ronald J. Williams di un lavoro, ora citatissimo, che nel 1986 rese popolare il primo metodo ben funzionante per il calcolo delle connessioni nelle reti neurali artificiali[1] –, in un’intervista di quei giorni a Le Monde (mia traduzione) su come funzionasse la novità, si dichiarava sorpreso.[2]

Per Hinton, non c'è dubbio che ChatGPT capisca molto di più di quello che si dice nei media. Eppure, durante la fase di addestramento, si supponeva che questo software imparasse semplicemente a prevedere la parola successiva in una frase, grazie a una quantità gigantesca di testo presentatogli. Come esseri umani, non abbiamo imparato la logica, l'aritmetica o la codifica dei computer completando testi esemplificativi, quindi perché e come lo fa? Il mistero è completo.

Sono infiniti gli esempi di successo della nuova tecnica degli LLM (Large Language Model), l’ultima per me è di ieri sera: la soluzione di un problema di programmazione su una tabella di dati sull’import-export mondiale, con più di un milione di righe, con il risparmio di qualche ora di studio e tentativi.[3] Che questo provenga da un sistema che sa solo giocherellare con il linguaggio prevedendo, come dice Hinton, la parola successiva in una sequenza di parole e poi ripetendo tante volte l’operazione sino alla fine, è sbalorditivo. Esco dal mio campo, che è quello di un economista che da oltre 50 anni scrive un codice informatico per costruire modelli, e mi spingo ad annotare che quella dell’emergenza dell’intelligenza da un meccanismo del linguaggio è una vera e propria scoperta.

Molti si sono impegnati a dimostrare che gli LLM non funzionano, spesso dimostrando soprattutto di essere loro a non aver ben capito come operano quei meccanismi. Frequenti le confutazioni con il caso del contadino che deve trasbordare un cavolo, una pecora e un lupo, potendone mettere solo due nella barca. Come fare, senza lasciare soli pecora e cavolo o pecora e lupo?[4] ChatGPT, il primo LLM divenuto disponibile – quasi due anni fa – se la cava benissimo perché di sequenze di parole di quel tipo ne ha viste certamente, ma se gli aggiungiamo l’indicazione che il lupo è vegetariano e mangia i cavoli, va in confusione, lasciando soli cavolo e lupo alla prima mossa.[5]

Ecco il punto, cioè la difficoltà del ragionamento in un ambito imprevisto, ed ecco la novità: ChatGPT versione o1 sa ragionare! Ad esempio, risolve situazioni imbarazzanti per i sapientoni automatici, come saperci dire: «Quante volte la vocale a compare in questa frase?» con la risposta «La vocale "a" compare 5 volte nella frase che hai scritto», ma… sono 7. Soprattutto, sa risolvere problemi logici o matematici di alto livello.

Come opera il nuovo modello, denominato anche strawberry (fragola)? È stato presentato da pochissimo e non ci sono ancora articoli scientifici scritti dai progettisti, se mai ci saranno; ci sono solo congetture[6] e anche, parrebbe, minacce a chi prova a esaminare il meccanismo.[7] Tutto si complica, con una specie di pendolo: dall’IA delle regole, che è stata protagonista della ricerca sino all’inizio del secolo, si è passati all’IA delle reti neurali artificiali, sui cui sono anche basati gli LLM; ora si stanno introducendo di nuovo strati e strati di regole? Certamente a breve capiremo di più, dissolvendo le nubi del marketing.

Intanto possiamo concentrarci sul rapporto sempre più complesso tra persone e macchine, quando impariamo da un dialogo con un LLM stravolgendo il rapporto maestro/allievo, che è di interazione ed empatia. Problema non banale, dato che il dialogo con un chatbot non ci lascia né indifferenti né annoiati, contrariamente a quel che si potrebbe immaginare.

Ecco che interviene da par suo il nostro baccelliere (piccolo, dice lui) di musica: se ragionare è difficile, ancora di più lo è insegnare a ragionare. Lo sperimentano i genitori con i figli, gli educatori con gli allievi. Il dialogo fra persone presuppone ascolto. Così come il ragionare implica la presenza di alternative. E le alternative scelte.

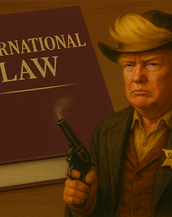

Ora, le scelte sono fortemente condizionate dalla cultura. La cultura è costituita di elementi consapevoli e di elementi che consapevoli non sono. E poi, come per incanto, arriva il marketing. Gli stessi che hanno fatto votare Ronald Reagan ai neri nel 1980, oggi tentano di far fare lo stesso ai poveri con Trump. “Comme puozzo raggiuna”, così canta Paolo Conte in una delle sue canzoni meno conosciute, Naufragio a Milano[8]. Siamo nel 1975 e Conte, malgrado abbia scritto Azzurro per Adriano Celentano, è ancora un outsider. L’Olympia di Parigi è dietro la curva della strada: non la vede lui e non la vede chi gli sta vicino. Nonostante questo, o forse proprio grazie alla consapevolezza di non dover difendere un successo non ancora conquistato, da astigiano scrive un pezzo in napoletano. Una canzone che racconta il naufragio a Milano di un immigrato, fra il paese volato via e un’assoluta, incurabile nustalgia, che ha un solo rimedio l’ammore disperato, antico, eterno. Chissà se l’IA, una volta che avrà imparato a “ragionare” proverà gli stessi sentimenti.

Note

[1] Rumelhart D. E., Hinton G. E., and Williams R. J. (1986). Learning internal representations by error propagation. In David E. Rumelhart and James L. McClelland, editors, Parallel Distributed Processing: Explorations in the Microstructures of Cognition, volume I, chapter 8, pages 318–362. MIT Press, Cambridge, MA.

[2] Hugues Bersini, Intelligence artificielle : « ChatGPT comprend beaucoup plus que nous le prétendons », Le Monde, 26 décembre 2023, https://www.lemonde.fr/article-offert/itnuxmhecirl-6207747/intelligence-artificielle-chatgpt-comprend-beaucoup-plus-que-nous-le-pretendons

[3] Vedere i riferimenti sub You are a Pandas expert, “prompt” mandato a ChatGPT, e la risposta sub To produce a https://github.com/terna/ImportExportAtlas/blob/main/useIEData.ipynb

[4] A https://wavenew.unipv.it/il-lupo-la-pecora-e-il-cavolo/ il problema è ben presentato, anche con la figura che riportiamo nello spillo.

Commenti